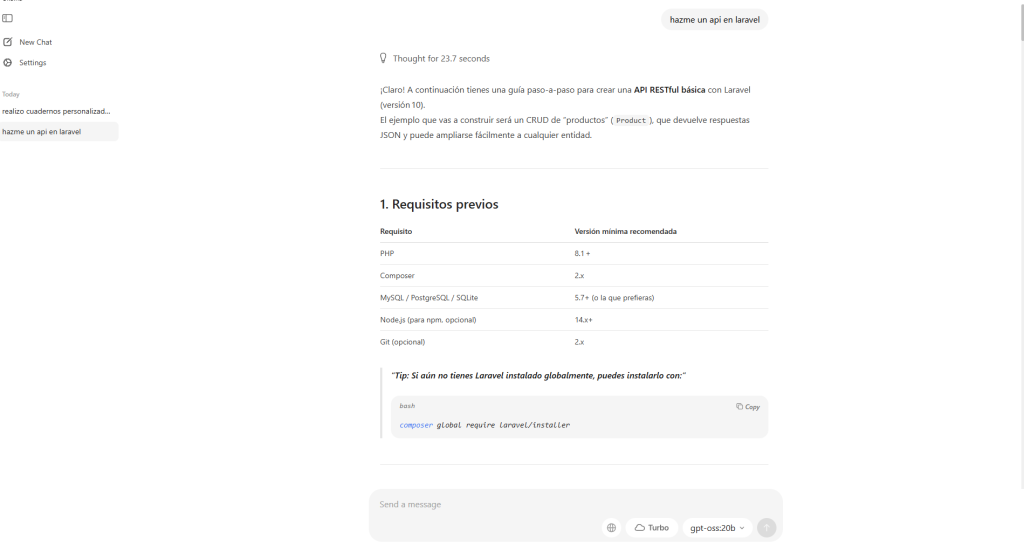

Ollama es una plataforma para ejecutar modelos de lenguaje locales con una experiencia de uso sencilla. Permite descargar, ejecutar y usar modelos como gpt-oss:20b y gpt-oss:120b en tu equipo, sin depender de la nube. La app ofrece interfaz gráfica (GUI) en Windows 11, linux y Mac OS además del tradicional CLI

Tabla de Contenido

ToggleModelos disponibles y objetivos

gpt-oss:20b y gpt-oss:120b son modelos open-weight lanzados por OpenAI bajo licencia Apache 2.0, diseñados para razonamiento avanzado, navegación, función de agentes y respuesta estructurada.

Requisitos técnicos

| Modelo | Requisitos mínimos | Requisitos recomendados |

|---|---|---|

| gpt-oss:20b | ~16 GB RAM o VRAM, 13 GB disco | GPU NVIDIA ≥16 GB (RTX 3090, 4080), sistema rápido |

| gpt-oss:120b | ~80 GB GPU memoria (A100, H100 o 4×24 GB) | Workstation con GPU ≥ 80 GB, NVLink o PCIe Gen4 |

| Ambos modelos | funciona en CPU con menor velocidad | GPU acelera significativamente la inferencia |

El formato MXFP4 reduce el tamaño gracias a la cuantización avanzada, permitiendo que los modelos se ajusten en memoria disponible.

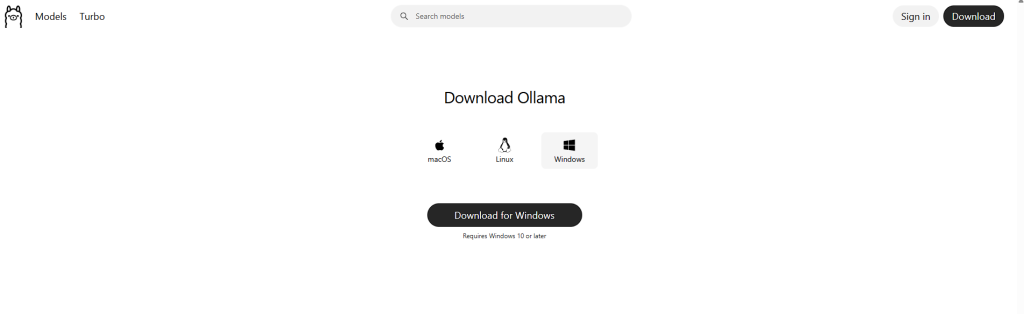

Instalación en Windows, Linux y MacOs

Accede a Ollama.com y descarga el instalador para Windows

Conexión con IDEs y APIs

API local: Ollama expone una API compatible con OpenAI, lo que permite usar el SDK de Python para integrarse con tu flujo de desarrollo.

Visual Studio / VS Code: Puedes usarlo mediante la API local; OpenAI Toolkit y Foundry Local ya integran el modelo en Windows con GPU optimizado.

Android Studio: Indirectamente puedes usarlo mediante scripts o servidor local (Ollama CLI o API HTTP) y consumir respuestas dentro de tu app Android. Aunque no hay integración directa, es viable mediante HTTP requests al servidor local.

Lo bueno y lo malo

** Lo bueno**

Modelos de razonamiento avanzados y accesibles localmente.

Flexibilidad para el desarrollo offline sin depender de la nube.

Soporte multiplataforma (Windows, Mac, Linux).

API compatible con OpenAI facilita integración.

Modelos licencitados de forma permisiva (Apache 2.0) .

** Lo malo**

Requisitos de hardware muy elevados, especialmente el modelo 120B.

Sin GPU, las velocidades son muy bajas (inferior a 10 token/s).

Configuración multi-GPU compleja y costosa.

Falta de integración nativa en IDEs como Android Studio.

Otros modelos con menos requisitos

Además de gpt-oss:20b y gpt-oss:120b, Ollama soporta modelos más pequeños que funcionan incluso en laptops o PCs sin GPU dedicada. Algunos ejemplos:

| Modelo | Tamaño aprox. | VRAM/CPU recomendada | Uso recomendado |

|---|---|---|---|

| LLaMA 3.2 3B | ~2–3 GB | CPU 8 GB RAM | Chat básico, asistentes rápidos, pruebas locales. |

| Mistral 7B | ~4 GB | GPU 6–8 GB VRAM o CPU | Traducción, resúmenes cortos, tareas de texto rápidas. |

| Gemma 2B | ~1.5 GB | CPU con 4–6 GB RAM | Bots ligeros, prototipado rápido, aplicaciones móviles. |

| Phi-3 Mini | ~2.5 GB | CPU o GPU 4 GB VRAM | Tareas de programación y razonamiento simple. |

Estos modelos son ideales para:

Probar Ollama sin invertir en hardware costoso.

Ejecutar IA en entornos de desarrollo móvil o integraciones IoT.

Mantener un consumo energético bajo.

Ollama permite instalar estos modelos con el mismo comando ollama pull, simplemente cambiando el nombre del modelo, por ejemplo:

ollama pull mistral

ollama run mistral

Conclusión

Ollama, junto con los modelos gpt-oss:20b y gpt-oss:120b, representa una solución potente y accesible para implementar inteligencia artificial sofisticada de forma local. Si bien requiere hardware exigente y cierta configuración, su compatibilidad con Windows, API abierta y potencia de razonamiento lo hacen ideal para desarrolladores que buscan independencia de la nube y flexibilidad en proyectos de IA avanzados.

pixie.haus

NotebookLM (Versión Gratuita 2026)